NVIDIA 於週一宣佈推出 HGX H200 Tensor Core GPU,採用 Hopper 架構,旨在加速 AI 應用。H200 是繼去年推出的 H100 後的新作,後者曾是 NVIDIA 最強大的 AI 晶片。若 H200 得到廣泛應用,可能會在不久的將來使 AI 模型變得更加強大,並加快現有模型如 ChatGPT 的反應速度。

專家指出,過去一年,計算能力不足一直是 AI 發展的主要瓶頸,阻礙了現有 AI 模型的部署並放緩了新模型的開發。導致這一問題的主要原因是強大的 GPU(加速 AI 模型的晶片)短缺。解決計算瓶頸的方法之一是製造更多晶片,另一種則是提升 AI 晶片的性能。後者可能使 H200 成為雲端服務提供商的理想選擇。

NVIDIA 的超級計算與高性能計算副總裁 Ian Buck 在新聞稿中表示:「為了用生成性 AI 和 HPC 應用創建智能,必須使用大型、快速的 GPU 記憶體,高效處理大量數據。」他還提到,憑藉 NVIDIA H200,這一行業領先的端到端 AI 超級計算平台的速度更快,可以解決一些世界上最重要的挑戰。

例如,OpenAI 曾多次表示其 GPU 資源不足,這導致 ChatGPT 的延遲。該公司不得不依賴速率限制來提供任何服務。從理論上講,使用 H200 可能會為運行 ChatGPT 的現有 AI 語言模型提供更多空間,以服務更多客戶。

據 NVIDIA 稱,H200 是首款提供 HBM3e 記憶體的 GPU。憑藉 HBM3e,H200 提供了 141GB 的記憶體和每秒 4.8TB 的帶寬,NVIDIA 認為這是 2020 年發佈的 NVIDIA A100 的記憶體帶寬的 2.4 倍。儘管 A100 已經上市多年,但由於更強大晶片的短缺,它仍然需求旺盛。

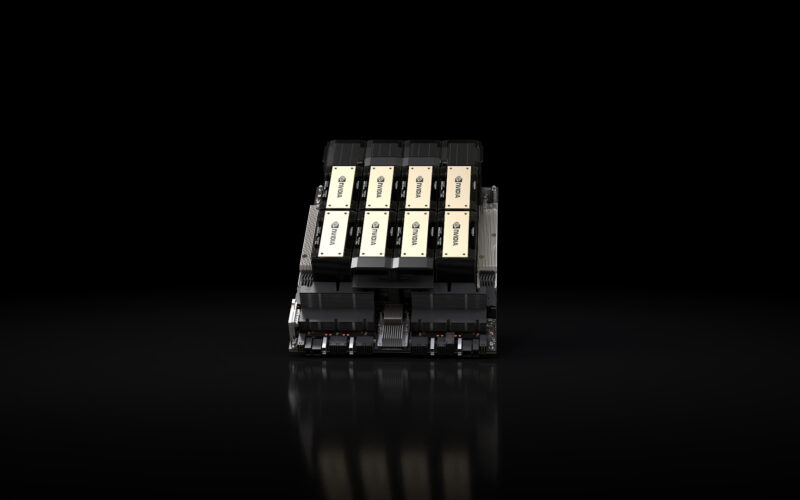

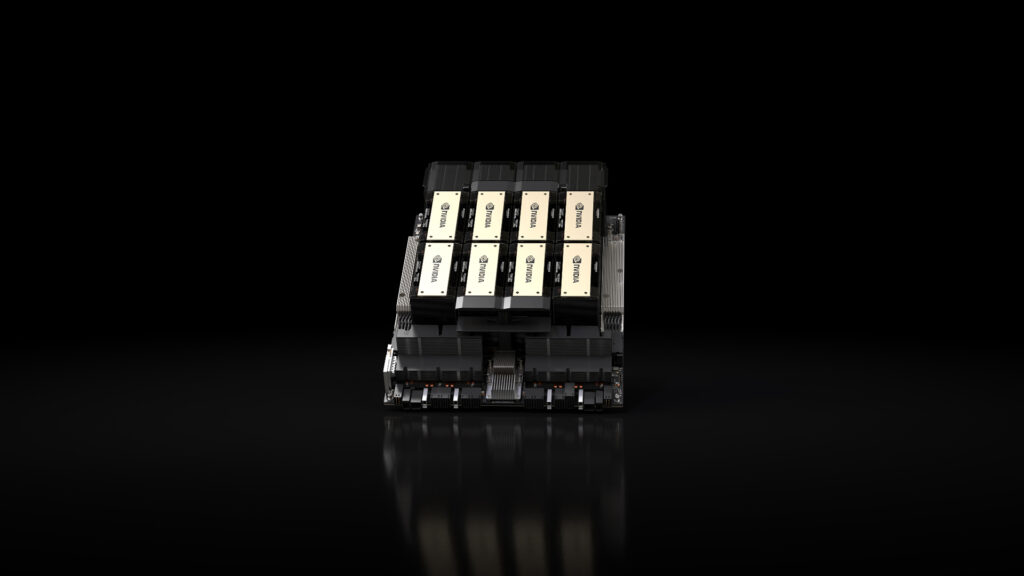

NVIDIA 將以多種形式推出 H200,包括四路和八路配置的 NVIDIA HGX H200 伺服器板,兼容 HGX H100 系統的硬體和軟體。它還將作為 NVIDIA GH200 Grace Hopper 超級晶片的一部分推出,該超級晶片將 CPU 和 GPU 結合在一起,為 AI 提供更大的性能提升。

Amazon Web Services、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure 將是首批部署基於 H200 的實例的雲服務提供商,預計將於明年開始。NVIDIA 表示,H200 將於 2024 年第二季度開始「在全球系統製造商和雲服務提供商」處可用。