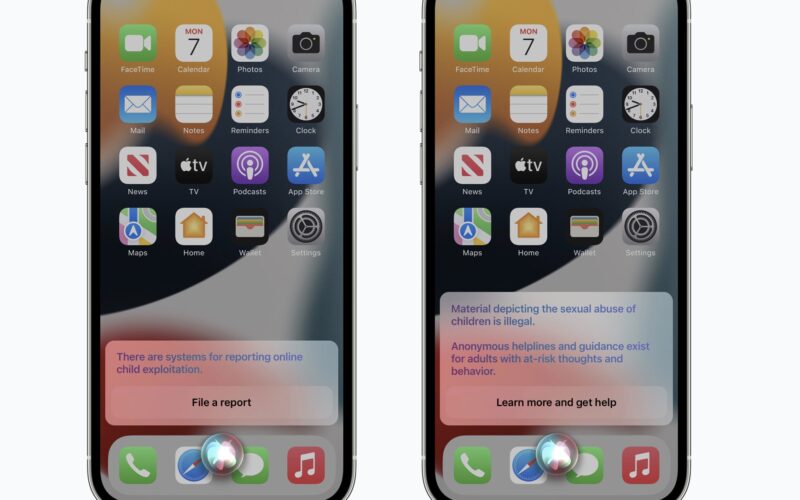

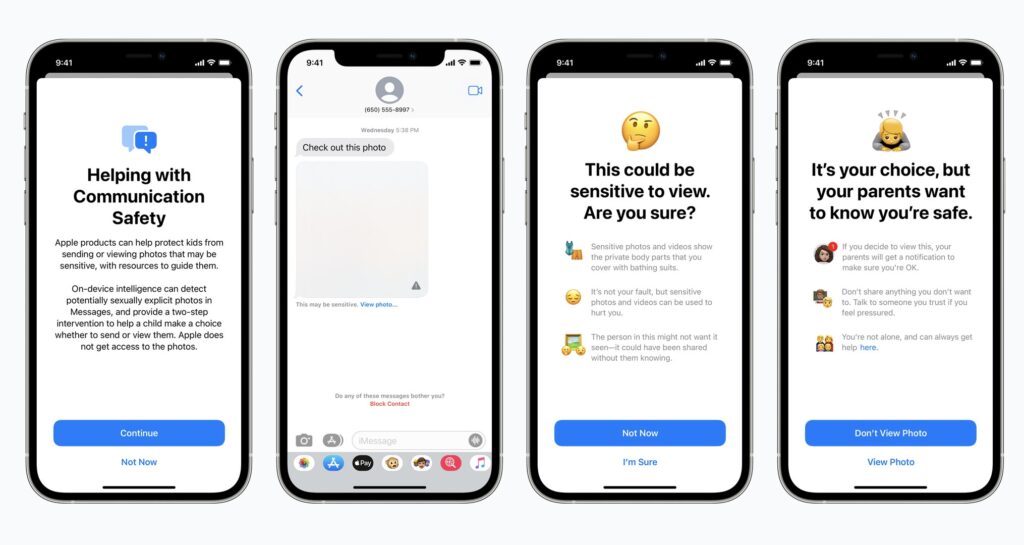

為了防止兒童色情照片傳播,Apple 早前宣佈將會在 iOS 15 開始,對 iCloud 上的照片進行掃描,找出 CSAM(兒童色情內容)。而有關措施已令全球 Apple 用戶對私隱感到憂慮。

兩位普林斯頓大學學者 Jonathan Mayer及 Anunay Kulshrestha 於華盛頓郵報撰文指出,Apple CSAM 系統是相當危險,他們表示「問題不在於我們誤解 Apple 這個系統如何運作,而是我們明白它如何運作。」若在一些政府的威迫下,可要求 Apple 找出一些政治相關的照片,當中受影響的裝置多達 15 億台。

而兩位學者在 2 年前已開始如何在點對點加密情況下掃描出 CSAM,方法既能夠保護用戶私隱又可找出 CSAM,現時仍在處於試驗性階段。